„ Sehr gute Beratung bei der Konzeption unserer App. " Ayse

„ Sehr gute Beratung bei der Konzeption unserer App. " Ayse

In unseren News finden Sie Fachartikel über allgemeine Themen Rund um IT

Datenverluste sind allgegenwärtig. In manchen Fällen kann eine Wiederbeschaffung gelingen, in anderen wiederum nicht. Aber soweit muss es gar nicht kommen, denn es gibt verschiedene Mittel zur Vorbeugung. In dieser Artikelserie, bestehend aus vier Teilen, beschäftigen wir uns mit Datensicherung.

Teil 1: Datenverlust - Wo lauern überhaupt die Gefahren?

Teil 2: Welche Techniken gibt es zur Datensicherung?

Teil 3: Wie funktioniert die 3-2-1 Back-up-Strategie?

Teil 4: Und wenn es zu spät ist, wie können Daten gerettet werden?

Bonus: Datenrettung bei versehentlich formatierten und mit VeraCrypt verschlüsselten Festplatten

Sie haben eine Festplatte versehentlich formatiert, welche Sie mit VeraCrypt verschlüsselt hatten? Kein Grund zur Panik! Ihre Daten können Sie unter bestimmten Voraussetzungen trotzdem noch wiederherstellen. In diesem Bonus-Teil unserer Artikelserie bieten wir hierfür eine Anleitung an:

ACHTUNG! Bitte lesen Sie den Artikel einmal komplett durch, bevor Sie beginnen!

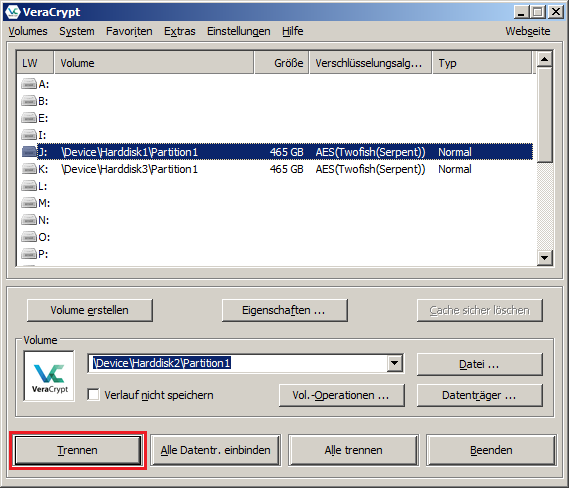

Schritt 1: Trennen Sie sofort Ihre Partition!

Wenn Ihr Volume noch eingehängt ist und das Passwort eingegeben wurde, hängen Sie dieses sofort aus! Es besteht die Gefahr, dass auf dieses noch versehentlich geschrieben wird.

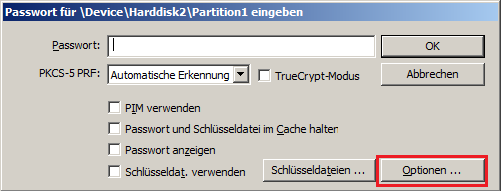

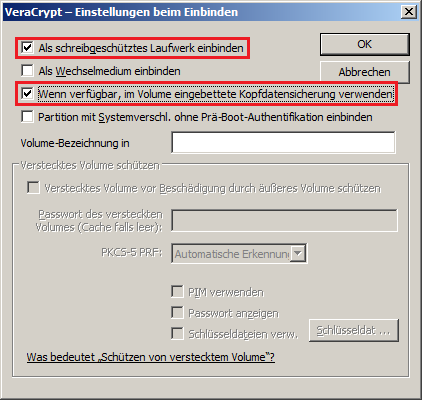

Schritt 2: Öffnen Sie das Volume mit bestimmten Einstellungen

VeraCrypt speichert die Kopfdaten des Volumes auf die Partition doppelt: Einmal am Anfang und einmal am Ende dieser. Da vermutlich die Kopfdaten am Anfang beschädigt sind, können Sie die Partition über die Kopfdaten am Ende einhängen:

Wenn Sie Operationen an der Partition vornehmen und es besteht nicht die Möglichkeit, dass Sie sie vorher noch einmal komplett spiegeln, dann öffnen Sie sie aus Sicherheitsgründen immer schreibgeschützt! Es besteht die Gefahr, dass versehentlich darauf geschrieben wird. Wenn Sie Ihre Daten möglichst intakt zurück bekommen wollen, vermeiden Sie unbedingt Schreibvorgänge!

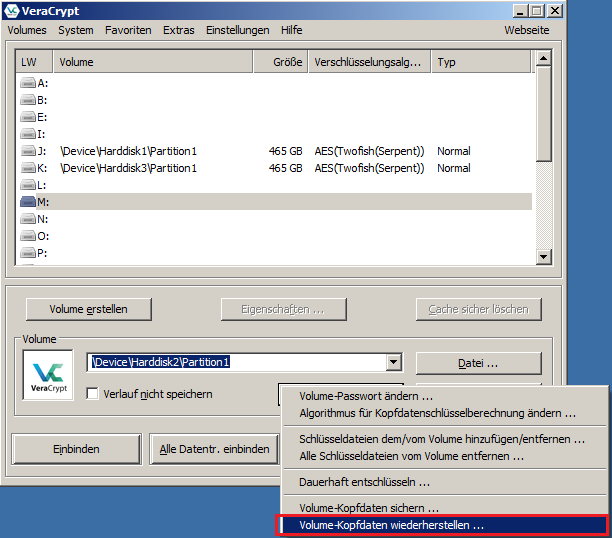

Wenn aber auch die Kopfdaten am Ende der Partition beschädigt sind, wären Ihre Daten an dieser Stelle endgültig verloren. Es sei denn, Sie haben die Kopfdaten vorher einmal extern gesichert. In diesem Fall stellen Sie diese unter VeraCrypt folgendermaßen wieder her:

Schritt 3: Stellen Sie Ihre Daten wieder her

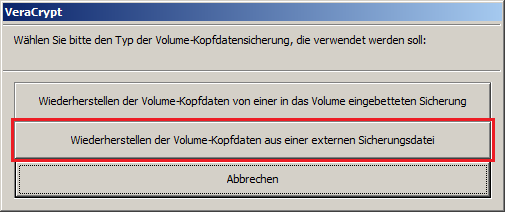

Nachdem Sie Ihr Volume erfolgreich einhängen konnten, werden Sie vermutlich die folgende Meldung beim Öffnen erhalten:

Das Volume ist in diesem Fall beschädigt und deswegen gibt es keinen Zugriff. Sie können aber auf Software zur Datenwiederherstellung zurück greifen, z. B. auf GetDataBack von Runtime. Je nachdem, mit welchem Dateisystem Ihre Partition formatiert wurde, wählen Sie entweder die NTFS- oder die FAT-Version aus. In diesem Beispiel setzen wir die Version für NTFS-Festplatten ein:

Wählen SIe "Systematic file system damage" aus. Diese Einstellung wird benutzt bei schnell formatierten Festplatten. Klicken Sie dann auf "Next".

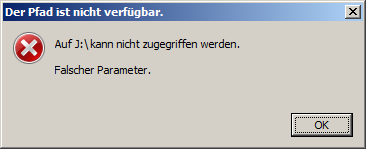

Da die Partition, aus der Sie Ihre Dateien wiederherstellen wollen mit VeraCrypt verschlüsselt ist, müssen Sie über die logische Ebene einen Scan vornehmen lassen. Deswegen wählen Sie unter dem Menüpunkt "Logical drives" das Laufwerk aus, in das Sie unter Schritt 2 Ihr Volume eingehängt haben. Darüber erfolgt der unverschlüsselte Zugriff. Klicken Sie anschließend auf "Next" und warten Sie dann, bis der Scan abgeschlossen ist. Dieser dauert u. U. mehrere Stunden. Im Anschluss daran werden Ihnen alle auf dem Datenträger befindlichen Partitionen angezeigt:

Wählen Sie die Partition aus, auf denen Ihre Daten ursprünglich vorhanden waren. Es kommt vor, dass GetDataBack mehrere Partitionen erkennt, obwohl auf diesem Datenträger nur eine vorhanden war. In diesem Fall wählen Sie einfach die größte, angezeigte Partition aus.

In diesem Fenster können Sie nun alle Ihre Daten wiedererlangen. Beim Kopieren sollten Sie aber darauf achten, dass Sie diese nicht auf den selben Datenträger zurückkopieren. Bis die Wiederherstellung vollständig abgeschlossen ist, sollten Sie deswegen auf einen externen Datenträger ausweichen, der ggf. vorher mit VeraCrypt zu verschlüsseln wäre. Beachten Sie auch, dass abhängig davon, wie viele Schreibvorgänge vorher auf dem Datenträger stattgefunden haben, evtl. nicht alle Ihre Daten wiederhergestellt werden können.

Datenverluste sind allgegenwärtig. In manchen Fällen kann eine Wiederbeschaffung gelingen, in anderen wiederum nicht. Aber soweit muss es gar nicht kommen, denn es gibt verschiedene Mittel zur Vorbeugung. In dieser Artikelserie, bestehend aus vier Teilen, beschäftigen wir uns mit Datensicherung.

Teil 1: Datenverlust - Wo lauern überhaupt die Gefahren?

Teil 2: Welche Techniken gibt es zur Datensicherung?

Teil 3: Wie funktioniert die 3-2-1 Back-up-Strategie?

Teil 4: Und wenn es zu spät ist, wie können Daten gerettet werden?

Trotz aller Sicherheitsmaßnahmen und Vorkehrungen sind Ihnen am Ende trotzdem Daten verloren gegangen? Noch wäre nichts zu spät, denn unter bestimmten Umständen lassen sich Ihre Daten alle wiederherstellen. In diesem Artikel beschäftigen wir uns damit, wie das gelingen kann.

Wenn Sie bemerken, dass auf Ihrem Computer Daten verloren gegangen sind, heißt es zunächst einmal: Ruhe bewahren! Überlegen Sie genau, in welchen Verzeichnissen Sie Ihre Dateien ursprünglich gespeichert haben bzw. auf welchem Datenträger sich diese befanden. Kontrollieren Sie an diesen Orten genau und vermeiden Sie dabei unbedingt, dass weitere Schreibvorgänge noch stattfinden! Je weniger Schreibvorgänge auf diesem Datenträger nämlich noch stattfinden, umso höher sind Ihre Chancen, dass Sie an Ihre Daten wieder herankommen.

Wenn Sie mit der Wiederherstellung von Daten in keinerlei Hinsicht vertraut sind, sollten sie am Besten Ihren Computer sofort ausschalten, indem Sie dessen Stecker einfach ziehen. Ja, Sie lesen richtig: Ziehen Sie den Stecker! Denn beim herunterfahren könnte das Betriebssystem noch weitere Schreibvorgänge vornehmen, welche potenziell eine Datenrettung weiter erschweren. Konsultieren Sie anschließend einen Informatiker Ihres Vertrauens oder wenden Sie sich an uns. Wir helfen Ihnen in dieser Sache gerne weiter.

Diese Empfehlung gilt übrigens auch bei Kryptotrojanern. Auch wenn die Frist, welche von diesen gesetzt wurde, droht abzulaufen, werden Ihre Daten nicht gelöscht, solange Ihr Computer ausgeschaltet bleibt.

Idealerweise haben Sie bereits vorgesorgt und haben auf Ihrem Computer schon lange für den Fall der Fälle Datenrettungsprogramme installiert. Wenn dem nicht so sein sollte, so wäre dies nicht unbedingt ein Problem. Sie können sich Datenrettungsprogramme auch aus dem Internet nachträglich noch herunterladen, Sie sollten diese nur nicht auf Ihrem Computer installieren. Es besteht die Gefahr, dass Sie dadurch die zu rettenden Daten überschreiben. Sie sollten daher bei Möglichkeit die portable Variante dieser Datenrettungsprogramme an einem anderen Computer herunterladen und auf einen USB-Stick kopieren. Diesen können Sie dann gefahrlos an Ihren Computer anstecken und die darin befindlichen Programme starten.

Grob werden Datenrettungsprogramme in zwei Arten unterschieden: Solche, die nur einfach gelöschte Dateien wiederherstellen können und solche, die für versehentlich formatierte Festplatten entwickelt wurden. Bei Ersterem hilft bspw. Recuva von Piriform. Bei Letzterem würde wiederum bspw. GetDataBack von Runtime in Frage kommen.

Bei kaputt gegangener Hardware kommt es nur darauf an, ob hiervon ein Datenträger betroffen ist. Wenn an Ihrem Laptop bspw. nur das Display kaputt gegangen ist, so bedeutet das nicht, dass Ihre Daten alle verloren sind. Die Festplatte Ihres Laptops kann nämlich ausgebaut und an einen anderen Computer angeschlossen werden. Hierüber könnten Sie dann wieder an Ihre Daten herankommen.

Ist aber ein Datenträger ohne Zweifel kaputt, so gibt es nur einen Weg, um an alle Daten wieder heranzukommen, nämlich die Übergabe an ein sog. Datenrettungslabor. Dieses gilt oft als die letzte Hoffnung für verloren gegangene Daten. Selbst Datenträger, welche durch Brand- oder Wasserschäden zerstört würden, können in diesen Laboren oft noch ausgelesen werden. Abhängig davon, um welches Medium es sich handelt, wie groß dieses ist sowie, wie schlimm die Schäden daran sind, können die Preise für eine Datenrettung mehrere hundert bis mehrere tausend Euro betragen. Wenn eine Datenrettung aber selbst unter laborbedingungen nicht mehr möglich ist, wären somit Ihre Daten endgültig verloren.

Auch ein intakter Datenträger kann für eine Datenrettung in ein Labor abgegeben werden. Aus Erfahrung können wir jedoch sagen, dass dieses keine besseren Ergebnisse bringt, als wenn Sie mit entsprechender Software Ihre Daten zu Hause selber retten.

Datenverluste sind allgegenwärtig. In manchen Fällen kann eine Wiederbeschaffung gelingen, in anderen wiederum nicht. Aber soweit muss es gar nicht kommen, denn es gibt verschiedene Mittel zur Vorbeugung. In dieser Artikelserie, bestehend aus vier Teilen, beschäftigen wir uns mit Datensicherung.

Teil 1: Datenverlust - Wo lauern überhaupt die Gefahren?

Teil 2: Welche Techniken gibt es zur Datensicherung?

Teil 3: Wie funktioniert die 3-2-1 Back-up-Strategie?

Teil 4: Und wenn es zu spät ist, wie können Daten gerettet werden?

Sich vernünftig aufzustellen und entsprechend zu organisieren ist das A und O jeder Datensicherung. Doch nicht wenige sind am Ende gescheitert, weil ihre Strategien im Katastrophenfall nicht aufgegangen sind. In diesem Teil unserer Artikelserie betrachten wir daher die sog. 3-2-1 Back-up-Strategie, welche am meisten genutzt wird und daher erprobt ist.

Nun gut, wir kennen nun potenzielle Gefahren für Datenverluste und einige Methoden, wie Daten vernünftig abgesichert werden können. Doch diese Informationen alleine genügen nicht, um einer Katastrophe in ausreichender Weise gewappnet zu sein. Es bedarf auch einer guten Strategie sowie einer Vorrichtung, damit Daten am Ende auch wirklich überleben.

Bevor überhaupt ein Back-up so wirklich durchgeführt werden kann, müssen zunächst zwei Dinge geklärt werden: Zum einen, welche Daten für eine Sicherung überhaupt infrage kommen und zum anderen, vor welchen Gefahren diese geschützt werden sollen. Von diesen beiden Faktoren abhängig, können die Kosten sowie der zeitliche Aufwand unterschiedlich ausfallen.

Bei Ersterem sollten regelmäßig zu sichernde Daten bei Möglichkeit auf dem Computer an solchen Orten gespeichert werden, die Ihnen als Anwender einen möglichst einfachen Zugang ermöglichen. Sie sollten es meiden, bei jedem Sicherungsvorgang zunächst alle Daten zusammensuchen zu müssen, denn Sie würden dadurch unnötig viel Zeit verlieren. Speichern Sie Ihre wichtigen Daten deshalb von Anfang an an einem Ort, den Sie mit quasi nur einem Mausklick direkt sichern können.

Wenn es um die potenziellen Gefahren geht und Sie Datenverluste durch Hardwareschäden bspw. vorbeugen möchten, sollten Sie darüber nachdenken, Ihren Computer mit einem RAID-System auszustatten. Gegen versehentliches Löschen, Datenverlust durch Softwarefehler oder durch einen Virenbefall hilft nur eine regelmäßige Datensicherung auf einem externen Datenträger. Müssen Ihre Daten aber am Ende auch bspw. einen Wohnungsbrand überleben, sollten Sie Ihre Daten zusätzlich noch in der Cloud speichern.

Rein statistisch betrachtet beträgt die Wahrscheinlichkeit im Schnitt 1 zu 100, dass ein Datenträger ausfällt. Auf diese Erfahrung setzt die 3-2-1 Back-up-Strategie an. Ein Anwender soll gleich drei verschiedene Sicherungskopien seiner Daten anlegen, um die Wahrscheinlichkeit eines Totalverlustes enorm zu minimieren. Hier die Rechnung dazu:

1/100 * 1/100 * 1/100 = 1/1.000.000

Bei drei Sicherungskopien ist die Wahrscheinlichkeit 1 zu 1.000.000, dass alle drei Datenträger gleichzeitig ausfallen. Erstellen Sie daher nicht nur eine, sondern gleich mind. drei Sicherungskopien Ihrer Daten, um einem Totalverlust zu entgehen.

Die Ausfallwahrscheinlichkeit eines Datenträgers kann variieren, je nachdem, aus welchem Material dieser besteht, welche Speichertechnologie dieser verwendet und wie frequentiert dieser genutzt wird. In der 3-2-1 Back-up-Strategie wird deswegen nicht nur zu drei Sicherungskopien angeraten, sondern dass diese bei Möglichkeit auch auf mindestens zwei verschiedenen Medien angelegt werden.

Wenn Ihre Daten bspw. hauptsächlich auf Magnet-Festplatten gespeichert werden, sollten Sie darüber nachdenken, mind. eine Sicherungskopie bspw. auf einer SSD anzulegen. Wenn es sich um geringe Datenmengen handelt, würden sich auch USB-Sticks oder Speicherkarten anbieten. Aber auch optische Datenträger, wie CDs, DVDs oder BDs würden sich eignen.

Die Beste Strategie nützt nichts, wenn Sie zwar alle Ihre Daten regelmäßig auf externe Datenträger kopieren, diese aber nahezu durchgehend in Ihrer Wohnung aufbewahren. Denn theoretisch besteht auch die Möglichkeit eines Totalverlustes durch einen Wohnungsbrand oder einen Wasserschaden. Die 3-2-1 Back-up-Strategie sieht daher die Aufbewahrung mind. einer Kopie Ihrer Daten außerhalb der gewohnten Umgebung vor. Machen Sie sich daher vertraut mit sog. online Back-up bzw. mit Cloud-Diensten, die hierfür Speicher zu Verfügung stellen. Sie sollten dabei Ihre Daten vernünftig verschlüsseln, sodass diese von Unbefugten ohne Weiteres nicht gelesen werden können.

Als digitale App-Agentur sind wir der ideale Ansprechpartner. Wir entwickeln ihre App, ganz nach ihren Wünschen.

Unsere App-Agentur in München hilft ihnen gerne bei der Entwicklung ihrer individuellen App im Bereich der Datensicherung, für die Plattformen iOS, iPadOS oder Android. Rufen Sie uns an unter 0176 75191818 oder senden Sie uns eine E-Mail an Diese E-Mail-Adresse ist vor Spambots geschützt! Zur Anzeige muss JavaScript eingeschaltet sein!.

Datenverluste sind allgegenwärtig. In manchen Fällen kann eine Wiederbeschaffung gelingen, in anderen wiederum nicht. Aber soweit muss es gar nicht kommen, denn es gibt verschiedene Mittel zur Vorbeugung. In dieser Artikelserie, bestehend aus vier Teilen, beschäftigen wir uns mit Datensicherung.

Teil 1: Datenverlust - Wo lauern überhaupt die Gefahren?

Teil 2: Welche Techniken gibt es zur Datensicherung?

Teil 3: Wie funktioniert die 3-2-1 Back-up-Strategie?

Teil 4: Und wenn es zu spät ist, wie können Daten gerettet werden?

In der heutigen Zeit stehen zum Glück verschiedene Mittel zur Auswahl, um einzeln oder auch kombiniert relativ sicher gegen Datenverlust vorbeugen zu können. In diesem Teil unserer Artikelserie sehen wir uns einzelne Methoden an und beschäftigen uns mit ihrem Nutzen bzw. ihren Vor- und Nachteilen.

Ob Daten bestimmte Katastrophen am Ende überleben können, hängt davon ab, mit welchen Mitteln diese vorher gesichert wurden. Dabei kommt es nicht nur auf die Anwendung bestimmter Mittel an, sondern auch darauf, ob wir Anwender bereit sind, gewissen Aufwand dafür zu betreiben. Im Folgenden werden mehrere Methoden vorgestellt, mit diesen eine Sicherung von Daten gelingen kann:

Die beliebteste Variante, um Daten zu sichern, ist die Sicherungskopie auf einem externen Datenträger. Dieser könnte bspw. ein USB-Stick sein, oder eine externe Festplatte. Aber auch optische Datenträger, wie CDs, DVDs, oder BDs bieten sich für regelmäßige Datensicherungen an.

Diese Methode bietet gleich mehrere Vorteile: Alle Daten sind gesichert, auch wenn Anwender auf ihren Computern versehentlich Daten löschen, oder durch fehlerhafte Software Daten verlieren. Der Computer könnte sogar vollständig kaputt gehen, ohne dass dabei wirklich Daten verloren gehen würden. Sollte der Computer mal mit Viren befallen werden, würden alle Daten sicher bleiben, solange der externe Datenträger nicht an diesen angeschlossen wird. Wird der externe Datenträger auch außerhalb des eignen Hauses aufbewahrt, können alle Daten darauf selbst Wasserschäden oder Brände überleben.

Der Nachteil dieser Methode ist aber wiederum, dass Anwender regelmäßigen Aufwand betreiben müssen, um immer eine aktuelle Sicherungskopie aller Daten zu haben. Dies könnte auf Dauer jedoch ganz lästig werden. Abhängig davon, in welchem zeitlichen Abstand eine Datensicherung regelmäßig durchgeführt wird, kann trotzdem ein gewisses Risiko bestehen, dass neue und noch nicht gesicherte Daten verloren gehen. Wenn die zu sichernde Datenmenge groß ist, würde der zeitliche Aufwand pro Sicherungsvorgang dementsprechend hoch ausfallen.

RAID-Systeme können ebenfalls in gewisser Weise gegen Datenverlust vorbeugen. Durch die Kombination mehrerer physischer Datenträger zu einer logischen wird dabei eine gewisse Redundanz erzeugt, die bis zu einem bestimmten Grad Sicherheit vor einem Ausfall bietet. Hierbei eignen sich am meisten die RAID-Level 1, 5 und 6 bzw. die Kombinationen davon sowie RAID-Level 10. RAID-Level 0 bietet keine Datensicherheit.

Der Vorteil dieses Systems ist, dass mindestens ein beliebiger Datenträger kaputt gehen kann, ohne dass dabei alle Daten verloren gehen. Das RAID-System arbeitet dabei voll automatisch und Anwender müssen für die Erzeugung der Redundanz keinen zusätzlichen Aufwand betreiben.

Wovor RAID-Systeme jedoch nicht schützen können, sind immer noch die Datenverluste durch menschliches Versagen oder durch Software-Fehler. Auch vor einem Virenbefall, vor Wasser- oder Brandschäden schützen derartige Systeme nicht. Je nachdem, wie ein RAID-System konstruiert wird, können hierbei hohe Kosten entstehen und es stünde nicht der gesamte Datenspeicher zu Verfügung, der eingekauft wurde. Wenn in einem RAID zu viele Datenträger ausfallen, sind alle Daten verloren, auch auf den Datenträgern, die noch intakt sind.

In unserer heutigen Zeit, wo schnelle Breitbandzugänge vorhanden sind, bieten natürlich auch Clouddienste die Möglichkeit an, Daten zu sichern. Hierbei wären Microsoft's OneDrive oder auch Google's Google Drive als Beispiele zu erwähnen.

Ein großer Vorteil dieser Clouddienste ist es, dass Daten vor nahezu jeder erdenklichen Gefahr gesichert sind. Egal, ob ein Anwender auf seinem Computer eine Datei einfach nur versehentlich gelöscht hat, oder ob sein ganzes Haus am Ende niedergebrannt ist, auf seine Daten in der Cloud kann er nach wie vor zugreifen. Solange ein Internetzugang vorhanden ist, kann von jedem Ort auf der Welt aus auf diese zugegriffen werden.

Ein wiederum großer Nachteil dieser Clouddienste ist es aber, dass der Datenschutz nicht immer gewährleistet ist. Anwender können nie sichergehen, dass Ihre Daten vor unberechtigten Zugriffen Dritter geschützt bleiben. Insbesondere die Cloudanbieter selbst könnten die Privatsphäre ihrer Nutzer verletzen. In den Fällen, wo große Datenmengen gesichert werden müssten, würden für zusätzlichen Speicher regelmäßige Kosten beim Cloudanbieter anfallen und ein Upload wurde zeitlich entsprechend viel länger dauern.

Datenverluste sind allgegenwärtig. In manchen Fällen kann eine Wiederbeschaffung gelingen, in anderen wiederum nicht. Aber soweit muss es gar nicht kommen, denn es gibt verschiedene Mittel zur Vorbeugung. In dieser Artikelserie, bestehend aus vier Teilen, beschäftigen wir uns mit Datensicherung.

Teil 1: Datenverlust - Wo lauern überhaupt die Gefahren?

Teil 2: Welche Techniken gibt es zur Datensicherung?

Teil 3: Wie funktioniert die 3-2-1 Back-up-Strategie?

Teil 4: Und wenn es zu spät ist, wie können Daten gerettet werden?

Datenverluste können manchmal nur bedauerlich, manchmal aber auch existenzbedrohend sein. Man denke als Beispiel an einen freiberuflich tätigen Grafiker, der seine Arbeit ausschließlich nur auf einem Computer verrichtet. Denkt dieser aber nie an regelmäßige Sicherungskopien, könnte ihn eines Tages eine Katastrophe wachrütteln. Wenn alle Daten nämlich erst mal weg sind und dieser seine Arbeit nicht mehr machen kann, könnten seine Auftraggeber als Folge alle Aufträge wieder zurückziehen. Möglicherweise würden sie sogar eine Vertragsstrafe einfordern, weil Termine nicht rechtzeitig eingehalten wurden. Und das ist nur ein denkbares Szenario, das in Folge eines Datenverlustes eintreten kann.

Wie aber kann Datenverlust überhaupt eintreten? Sehen wir uns nachfolgend mal einige Möglichkeiten an:

Klassischerweise gehen Daten dadurch verloren. dass eine Datei versehentlich gelöscht, oder eine Festplatte versehentlich formatiert wird. Aber auch andere Formen von Datenverlust können eintreten, z. B. dadurch, dass unachtsamen Nutzern ihre Festplatten auf den Boden fallen, oder sie ein Getränk über ihre Laptops verschütten. Smartphones, Tablets und USB-Sticks können nicht nur Flüssigkeiten ausgesetzt werden, sie können auch einfach nur unauffindbar verloren gehen.

Software und insbesondere auch Betriebssysteme können ebenfalls eine Ursache für Datenverlust darstellen. Man denke bspw. an das Windows 10 Upgrade 1809. Nach einer Aktualisierung waren die Inhalte der Ordner "Dokumente" sowie "Bilder" unter "Eigene Dateien" verschwunden. Als Folge stoppte Microsoft die Auslieferung dieses Upgrades temporär, um weitere Schäden zu vermeiden.

Ein weiteres Beispiel ist die fehlerhafte Firmware einer Netzwerkspeichereinheit von QNAP, welche im August 2017 ausgebessert wurde. Entgegen der Regel sind bei einem RAID 5 Datenverluste eingetreten, obwohl nur eine Festplatte ausgefallen war.

Wie alle physischen Gegenstände in unserem Leben, unterliegen selbstverständlich auch unsere Computer bzw. unsere Datenträger einem gewissen Verschleiß. Dieser kann ebenfalls am Ende dazu führen, dass Daten verloren gehen. Bspw. dadurch, indem eine Festplatte einfach kaputt geht. Auch unsere Flashspeichermedien halten nicht unbegrenzt. Diese sind aus einem Material hergestellt, welche eine zwar sehr hohe, aber auch nur begrenzte Anzahl an Lese- bzw. Schreibvorgänge zulässt.

Eine weitere Gefahrenquelle ist potenziell auch die Stromzufuhr, denn nicht wenig Hardware geht dadurch kaputt, weil sie überspannt wird. Auch ab Werk können Hardware wegen Produktions- oder Konstruktionsfehler Defekte haben.

Viren und Trojaner waren gerade in der jüngeren Vergangenheit viel Ursache für Datenverluste. Im März 2016 machte bspw. KeRanger die Runde, im Mai 2017 dann WannaCry. Bei diesen Exemplaren handelt es sich um sog. "Kryptotrojaner", die sämtliche Dateien verschlüsseln, nachdem sie auf einen Computer gelangt sind. Im Anschluss daran erpressen sie vom Anwender Lösegeld und drohen mit endgültiger Löschung aller Daten, sollte dieser nicht bezahlen.

Einflüsse durch die Umwelt können ebenfalls am Ende zu Datenverlust führen. Dabei muss ein Computer noch nicht einmal eingeschaltet sein. Stellen Sie sich vor, durch einen Rohrbruch erleiden Sie ausgerechnet in dem Raum einen Wasserschaden, in dem Ihre Arbeitsgeräte liegen. Oder in Ihrem Raum fängt irgendein Gerät Feuer wegen eines Kurzschlusses. Brände, Wasserschäden, Blitzeinschläge, zu hohe oder zu niedrige Temperaturen oder auch Erdbeben in manchen Regionen können zu verheerenden Datenverlusten führen.

Als digitale App-Agentur sind wir der ideale Ansprechpartner. Wir entwickeln ihre App, ganz nach ihren Wünschen.

Unsere App-Agentur in München hilft ihnen gerne bei der Entwicklung ihrer individuellen App im Bereich der Datensicherung, für die Plattformen iOS, iPadOS oder Android. Rufen Sie uns an unter 0176 75191818 oder senden Sie uns eine E-Mail an Diese E-Mail-Adresse ist vor Spambots geschützt! Zur Anzeige muss JavaScript eingeschaltet sein!.

Tag täglich landen Menschen auf gefälschten Webseiten und werden entweder Opfer von Identitätsdiebstahl, oder sie erleiden einen finanziellen Schaden. Dies erreichen Kriminelle nicht nur ganz klassisch mittels Phishing über Spammails, sondern auch mittels sog. Pharming. In diesem Artikel beleuchten wir, wie sie dabei vorgehen und wie ein sicherer Schutz davor aussehen kann.

Sie waren immer vorsichtig und haben nie auf Links in verdächtigen Mails geklickt? Das Bankkonto wurde aber trotzdem leer geräumt? Oder jemand anderes kontrolliert nun Ihr Konto bei Facebook? Dann sind sie möglicherweise Opfer eines sog. Pharming-Angriffs geworden.

Genau wie beim Phishing, sollen auch beim Pharming ahnungslose Benutzer auf eine präparierte Webseite angelockt werden, mit dem Zweck, um sie dann zu betrügen. Dies könnte z. B. die Webseite einer Bank sein. Wer dort aber seine Zugangsdaten für das Online-Banking eingibt, wird hinterher feststellen, dass Kriminelle sich am eigenen Bankkonto bedient haben.

Es gibt nur einen Unterschied zwischen Pharming und Phishing: Um potenzielle Opfer anzulocken, müssen beim Pharming nicht massenhaft gefälschte E-Mails verschickt werden. Stattdessen werden sog. DNS-Abfragen manipuliert, damit potenzielle Opfer so unbemerkt auf einer präparierten Webseite landen. Diese Art der Manipulation ist nämlich viel unauffälliger als das Phishing. Eine gefälschte und massenhaft verschickte Mail würde zwangsläufig auch bei solchen Empfängern landen, die gar kein Konto bei der jeweiligen Bank besitzen. Diese würden den Betrug dann sofort merken und evtl. auch Schritte dagegen einleiten.

DNS-Abfragen können mit verschiedenen Mitteln manipuliert werden. Ganz klassisch könnte bspw. ein Trojaner dafür eingesetzt werden. Dieser muss nur auf dem Computer eines potenziellen Opfers einen Eintrag in der sog. "Hosts"-Datei erstellen. Darin befindet sich die Domain seiner Bank sowie der Verweis auf die IP-Adresse eines Servers, auf dem sich die präparierte und falsche Webseite befindet. Gibt dieser Benutzer in die Leiste seines Browsers nun die Adresse seiner Bank ein, würde er automatisch auf der gefälschten Webseite landen.

Sich davor schützen können sich Benutzer nur, indem sie auf das grüne Schloss neben der Adressleiste in ihrem Browser achten. Angreifer können nämlich keine Sicherheitszertifikate für Domains ausstellen, welche ihnen nicht gehören. Fehlt das grüne Schloss oder meldet der Browser eine unsichere Verbindung, bedeutet das: Finger Weg! Diese Webseite ist potenziell gefährlich!

Eine derartige Attacke kann aber auch auf einer ganz hohen Ebene stattfinden, z. B. auf einem viel frequentierten DNS-Server. Dieser speichert die IP-Adressen bereits abgefragter Domains in einem Cache, um Abfragen bei übergeordneten Servern nicht ständig wiederholen zu müssen. Wird der Cache nun aber manipuliert, können damit Scharen von Benutzern auf eine falsche Webseite umgeleitet und ausgenommen werden. Auch dies könnte mittels eines Trojaners bewerkstelligt werden oder durch die Ausnutzung einer Sicherheitslücke in der DNS-Server-Software. In diesem Zusammenhang spricht man auch von einem sog. Cache Poisoning.

Einer Manipulation des Caches können am effektivsten nur Inhaber von Domains begegnen, indem sie ihre sog. DNS-Zonendaten mit einer kryptografischen Signatur versehen. Bei jeder Abfrage wird diese durch den Empfänger dann überprüft und sollte diese abweichen, liegt potenziell eine Manipulation vor. Domain-Inhaber sollten sich daher bei Möglichkeit mit DNSSEC vertraut machen. Auch wir beraten Sie in dieser Angelegenheit gern.

Das Domain Name System - oder kurz DNS - ist eines der wichtigsten Komponenten des Internets. Es löst sog. Domainnamen in IP-Adressen auf und hat darüber hinaus auch einige Sicherheitsfunktionen. Warum aber wird dieses System überhaupt gebraucht? Und wieso wird es in Zukunft sogar eine noch größere Bedeutung haben? Darüber handelt unser heutiger Artikel.

Hinter allen Domainnamen, wie bspw. "google.de", verbergen sich IP-Adressen. Bevor ein Client aber eine Verbindung aufbauen kann, muss dieser vorher eine Abfrage tätigen. Erst dann kann ein Dienst im Internet erreicht werden.

Webseiten bspw. könnten selbstverständlich auch über ihre IP-Adresse abgerufen werden. Dies würde den Alltag aber nicht unbedingt erleichtern, denn Menschen können sich diese i. d. R. nicht merken. Domainnamen wurden deswegen eingeführt, damit zum einen Computer immer noch über IP-Adressen miteinander kommunizieren können und zum anderen, damit Dienste im Internet jederzeit ein Wechsel ihrer IP-Adresse vornehmen können, ohne dass sie diese jedes Mal neu propagieren müssen. Solange ein Domainname existiert und nicht abgeändert wird, ist eine Erreichbarkeit sozusagen einfach und garantiert.

Domainnamen werden meistens von DNS-Servern in IP-Adressen aufgelöst. Sie sind, wenn man so will, die Telefonbücher des Internets. Zuerst aber schaut das Betriebssystem, ob zu einer bestimmten Domain ein Eintrag in der sog. "Hosts"-Datei besteht. Erst dann tätigt es eine Abfrage bei einem DNS-Server. Weis dieser die IP-Adresse aber auch nicht, wendet sich dieser dann an einen sog. "Root-DNS-Server", quasi der große Bruder des DNS-Servers. Wenn der Domainname auch wirklich existiert, reicht dieser dann die IP-Adresse an das Betriebssystem durch.

Provider, wie die Telekom oder Vodafone, stellen für die Anschlüsse ihrer Kunden automatisch eigene DNS-Server bereit. Diese werden als Standardkonfiguration im Router eingetragen und dienen dann für Abfragen als Anlaufstelle. Selbstverständlich können auch alternative DNS-Server verwendet werden, denn es besteht keine Pflicht, die Provider eigenen zu benutzen.

IP-Adressen sind natürlich nicht die einzigen Daten, die zu einer Domain hinterlegt werden können. DNS erledigt inzwischen viel mehr Aufgaben, als nur Domainnamen in IP-Adressen aufzulösen. So kann zu einer Domain z. B. eine Aliasbezeichnung eingetragen werden, damit Besucher, die bspw. "post-bank.de" in ihren Browser eingeben, automatisch zur richtigen Domain, nämlich "postbank.de", weitergeleitet werden können. Oder es können Mailserver eingetragen werden, damit ein Empfang von Mails über die eigene Domain möglich wird.

Bestimmte Sicherheitsmerkmale, wie z. B. DNSSEC, stellen sicher, dass tatsächlich auch die Webseite von Facebook im Browser erscheint, wenn "facebook.com" in die Adressleiste eingegeben wird. Wenn dies nicht durch technische Mittel sichergestellt wird, können Besucher durch das sog. "Cache Poisoning" auf eine gefälschte Version des sozialen Netzwerks umgeleitet werden. Geben sie nun dort ihre Log-in-Daten ein, würden diese wahrscheinlich auf direktem Weg in die Hände von Kriminellen Hackern gelangen.

Langfristig sollen alle IPv4-Adressen durch IPv6-Adressen ersetzt werden. Diese haben eine Länge von 128 Bit und werden in hexadezimal dargestellt. Dadurch werden sie für den Menschen sogar noch schwieriger sein zu merken. IPv4-Adressen haben hingegen nur eine Länge von 32 Bit und werden in dezimal dargestellt. Hier ein Beispiel:

IPv4: 127.234.218.199

IPv6: 2001:0DB8:85a3:08d3:1319:8a2e:0370:7347

Viele Länder weltweit zensieren das Internet. Die Motive dabei sind ganz unterschiedlich: Sie können von politischer oder moralischer Natur sein, nicht selten geht es aber auch um den Schutz Minderjähriger oder um die eigene Religion. Doch an welchen Mitteln können sie sich dabei potenziell bedienen? Und wie zuverlässig arbeiten diese? Darüber handelt unser heutiger Artikel.

Benutzer davon abzuhalten, Zugang zu bestimmten Inhalten im Internet zu bekommen, kann manchmal keine einfache Aufgabe sein. Der Erfolg ist aber abhängig davon, welche Technik verwendet wird und wie versiert ein Benutzer ist, diese zu umgehen.

Die einfachste und kostengünstigste Methode, um Inhalte im Internet zu zensieren, ist die sog. DNS-Sperre. Alle Internet Service Provider müssen für ihre Infrastruktur technisch bedingt sog. DNS-Server betreiben. Diese können mit schwarzen Listen ausgestattet werden, in denen die Domains aller Webseiten eingetragen werden, die nicht erwünscht sind. Wenn Benutzer in die Adressleiste ihres Browsers nun eines dieser Domains eingeben, bekommen sie entweder einen Hinweis, dass der Zugang blockiert wurde, oder die Webseite ist einfach nicht erreichbar.

Diese Methode wird jedoch als sehr schwach angesehen. Benutzer können sie dadurch umgehen, indem sie in ihre Systeme alternative DNS-Server eintragen. Bei der Auswahl dieser muss nur darauf geachtet werden, dass diese von keiner Zensur betroffen sind. Gelegentlich bedienen sich manche Länder deswegen noch zusätzlich an der Sperrung von IP-Adressen dieser unerwünschten Domains, um den Zugang zusätzlich noch zu erschweren.

Eine weitere Möglichkeit, um Inhalte im Internet zu zensieren, ist ein sog. transparenter Proxy. Proxys stellen in Kommunikationsnetzwerken eine Art Vermittlung dar. Sie empfangen von anderen Kommunikationsteilnehmern Anfragen, leiten diese weiter an den Empfänger und fungieren dabei als Absender. Die Anfragen müssen derweil nicht so ohne Weiteres einfach übertragen werden, denn sie können auch abgeändert oder sogar ganz abgelehnt werden.

Abhängig davon, um welches Kommunikationsprotokoll es geht, arbeiten Proxys ganz unterschiedlich und müssen deswegen separat betrieben werden. Zum zensieren werden daher meistens sog. HTTP-Proxys eingesetzt. Diese werden von Providern unbemerkt (daher auch die Bezeichnung "transparent") zwischen den Anschlüssen ihrer Kunden und dem Internet geschaltet.

Anders als bei den DNS-Sperren muss dabei nicht die gesamte Domain gesperrt werden, es können auch nur einzelne URLs einer Webseite betroffen sein. Der Nachteil ist aber wiederum, dass diese Methode dadurch umgangen werden kann, indem die Kommunikation auf einen anderen Port umgelegt wird.

Der absolute Meister in Sachen Zensur ist die sog. Deep Packet Inspection. Sie werden von Providern ähnlich wie ein transparenter Proxy zwischen den Anschlüssen ihrer Kunden und dem Internet geschaltet. Unabhängig davon, über welchen Port kommuniziert wird, analysiert eine Firewall die Inhalte aller passierenden Datenpakete und gibt sie entweder frei oder blockiert sie. Die Kriterien können dabei sehr vielfältig sein, auf Grundlage derer die Firewall eine Entscheidung trifft. Dies können bspw. bestimmte verbotene Stichworte sein wie "Sex" oder "Porno", oder URLs mit unerwünschtem Inhalt, IP-Adressen, Domains und sogar bestimmte Kommunikationsprotokolle wie bspw. BitTorrent, VPN oder TOR. Es bestehen sozusagen keine Grenzen dessen, was verboten werden kann.

Es gibt nur einen wirksamen Schutz gegen Deep Packet Inspection, nämlich die sog. Protokoll-Obfuskation. Hierbei wird die eigentlich stattfindende Kommunikation in gewisser Weise verschleiert bzw. an der Firewall vorbei geschmuggelt. Die Inhalte, die dabei übertragen werden, sind zusätzlich noch verschlüsselt. Ob und in wieweit ein Benutzer mit dieser Methode aber durchkommt, hängt von der Intelligenz der verwendeten Technik des Providers ab.

Dateien müssen auf unseren Datenträgern in irgendeiner Weise organisiert werden. Ohne eine verlässliche Speicherstruktur wäre eine Arbeit undenkbar. Was muss der Computer aber im Hintergrund dafür alles unternehmen? Und welche Rolle spielen dabei MBR und GPT? Das sehen wir uns in diesem Artikel mal genauer an.

Seitdem Computer Daten verarbeiten und speichern, werden Dateisysteme gebraucht. Eine funktionierende Organisation ist dabei unerlässlich, vor allem wenn es um schnelle Zugriffe und um Integrität aller Daten geht. Genau hier kommen MBR und GPT ins Spiel.

MBR - oder der Master Boot Record - wurde während den 1980er Jahren für Festplatten entwickelt. Er dient zum einen als Startprogramm für BIOS basierte Computersysteme und als Organisator aller Partitionen auf einer Festplatte. Er befindet sich immer im ersten Sektor und ist nur 512 Byte groß.

Wenn Computer hochgefahren werden, geht das BIOS irgendwann dazu über, den MBR der Startfestplatte auszulesen. In diesem findet es alle notwendigen Informationen, um das Betriebssystem zu finden und zu starten. Gleichzeitig stellt der MBR eine Tabelle bereit, indem alle Partitionen einer Festplatte eingetragen sind. Das Betriebssystem soll dadurch auf einen Blick sofort erkennen, wie viele Partitionen existieren und wo diese sich auf der Festplatte befinden.

Partitionen wiederum haben Dateisysteme, die wiederum Dateien organisieren. Ein Dateisystem könnte unter Windows z. B. NTFS oder exFAT sein. Sie enthalten ebenfalls Tabellen, in denen alle Dateien u. a. mit Namen und Speicherort eingetragen sind.

Im Prinzip ist die Organisation unserer Dateien also verschachtelt: Der MBR organisiert alle Partitionen auf einer Festplatte, die Partitionen haben Dateisysteme, die wiederum alle Dateien organisieren.

Im Laufe der Jahre kamen immer neuere und modernere Speichermedien auf den Markt und die Kapazitäten wuchsen rasant an. MBR ist zweifelsohne eine sehr wichtige Komponente zur Organisation von Partitionen, er genügt jedoch den Anforderungen von heute nicht mehr. Daher beschloss die Industrie die Entwicklung von GPT und definierte die Organisation von Partitionen auf Datenträgern neu.

GPT - oder die GUID Partition Table - tut im Prinzip nichts anderes als MBR. Die Entwickler gingen dabei mit der Zeit und richteten sie nicht auf BIOS basierte, sondern auf UEFI basierte Computersysteme aus. Während bei MBR max. vier Partitionen in die Tabelle eingetragen werden können, können mittels GPT im Prinzip so viele Partitionen in die Tabelle eingetragen werden, wie der Datenträger an Speicher zu Verfügung stellt. Eine Partition ist dabei wie bei MBR nicht auf die Größe von max. 2 TiB beschränkt, sondern kann bis zu 18 EiB groß sein. Neu bei GPT sind auch sog. Back-up-Sektoren, in denen Informationen redundant abgelegt werden und die Datenverlust geringfügig vorbeugen. Jede Partition und der Datenträger selbst ist mit einer sog. GUID versehen, anhand der eine eindeutige Identifizierung erfolgen kann.

Aus Kompatibilitätsgründen hält GPT im ersten Sektor des Datenträgers aber immer noch den MBR. Diese enthält lediglich die Information, dass der gesamte Datenträger belegt ist und hat ansonsten keinerlei Funktion.

Wir treffen vereinzelt immer noch auf Computersysteme an, dessen Festplatten mit MBR initialisiert sind. Dies betrifft jedoch fast ausschließlich Rechner der älteren Generationen bzw. mit älteren Betriebssystemen. Auch ältere Datenträger können mit GPT initialisiert werden. In dieser Angelegenheit beraten wir Sie gern.

Internet Service Provider überschlagen sich immer mehr mit neuen Angeboten für höhere Bandbreiten und günstigere Preise. Dabei werben aber nicht nur reine DSL-Anbieter mit Festnetzanschlüssen, sondern auch Kabel- und Mobilfunkanbieter sind längst mit eigenen Angeboten auf dem Markt. Können diese aber mit DSL-Anbietern mithalten? In diesem Artikel schauen wir das mal genauer an.

Im Zuge des Ausbaus und Anbindung privater Haushalte ans Internet wurden Techniken gebraucht, mittels dieser ein Zugang über vorhandene Leitungen hergestellt werden sollten. Dabei wurde nicht nur ganz klassisch auf die vorhandene Telefonleitung angesetzt, sondern auch das Fernsehkabelnetz und das Mobilfunknetz sind als Zugangsmedien in Betracht gekommen.

DSL ist eine Übertragungstechnik, mittels dieser ein Zugang ins Internet über eine Zwei-adrige Kupferleitung (i. d. R. Telefon) hergestellt wird. In Ballungszentren werden darüber derzeit Bandbreiten von bis zu 250 Mbit/s im Downstream angeboten. In Gegensatz zu Kabel oder Mobilfunk verfügen alle Teilnehmer über ihre eigene Leitung und es kann daher ohne weiteres kein Engpass im Netz eintreten. Es ist weltweit das am meisten verwendete Zugangsverfahren für das Internet.

Betrachten wir zunächst einmal die Architektur eines Fernsehkabelnetzes: In Gegensatz zum Telefonnetz gab es im Fernsehkabelnetz ursprünglich kein Rückkanal. Als in den 1970er Jahren in Deutschland dessen Ausbau begonnen wurde, ist darüber lediglich ein Empfang von Fernsehinhalten vorgesehen gewesen. Das Internet spielte dabei keine Rolle. Die Anbindung aller Haushalte erfolgte in einer sog. Baum-Topologie, was einen Zugang ins Internet erheblich erschwerte. Daher kam das Fernsehkabelnetz zunächst einmal nicht als Zugangsmedium in Betracht.

Erst nach der Jahrtausendwende wurde das Fernsehkabelnetz nach und nach mit einem ein Rückkanal ausgestattet. Der Zugang ins Internet erfolgte nun mittels der sog. DOCSIS-Technologie. Alle Teilnehmer wurden anhand der MAC-Adresse ihrer Router unterschieden und surften über ihr eigenes Frequenzband. In Gegensatz zu DSL können mittels DOCSIS sehr hohe Bandbreiten im Fernsehkabelnetz günstiger angeboten werden. Kabelanbieter sind bereits heute schon in der Lage, Bandbreiten von bis zu einem Gbit/s anzubieten.

Ein Nachteil wiederum ist es aber, dass durch die Baum-Topologie im Fernsehkabelnetz Engpässe entstehen, wenn sehr viele Teilnehmer auf einmal im Internet surfen und downloaden. Einfache Mieter einer Wohnung sind darüber hinaus auf ihren Kabelanbieter Vorort angewiesen. Wenn dieser aber bestimmte Leistungen oder sogar gar kein Internet anbieten kann, könnte nur der Hauseigentümer einen Wechsel vornehmen.

LTE - oder das Mobilfunknetz allgemein setzt auf keine physische Leitung, d. h. der Zugang ins Internet erfolgt terrestrisch. Mobilfunkbetreiber limitieren fast immer dabei den Datenverkehr über ihr Netz. Daher können bspw. Streamingdienste nicht unbegrenzt oft genutzt werden. Zudem kann ein Engpass eintreten, wenn viele Teilnehmer auf einmal über dieselbe Basisstation surfen und downloaden.

Im Ballungszentrum, wo DSL mit hohen Bandbreiten i. d. R. verfügbar wäre, ist ein Festnetzanschluss mittels LTE daher eher unattraktiv. Auf dem Land jedoch, wo DSL wenig oder sogar gar nicht vorhanden ist, haben Mobilfunkbetreiber oft die Gelegenheit genutzt und ihr Netz entsprechend gut aufgestellt. Hier wäre ein Festnetzanschluss mittels LTE tatsächlich die bessere Alternative.

Abhängig von Ort und Lage jedoch, kann das Mobilfunksignal besser oder schlechter empfangen werden. Möglicherweise müssten Router deswegen entweder auf dem Fensterbrett aufgestellt oder mit einer externen Antenne versehen werden.

Kabel- und Mobilfunkanbieter können nicht immer mit DSL mithalten. I. d. R. sind diese zwar günstiger, jedoch müssen Nutzer gewisse Abstriche hinnehmen.

In unserem Teil 1: "Was ist VPN und wofür wird es benötigt?" haben wir bereits erfahren wofür VPN benötigt wird. In dem zweiten Teil erfahren wir welche Vorteile eine VPN-Verbindung gegenüber einer normalen Verbindung zu einem Server hat.

„Wer VPN benutzt, macht sich verdächtig um illegale Dinge im Word-Wide-Web zu erledigen“, denken vermutlich die meisten von Ihnen. Jedoch ist diese Annahme nicht korrekt. VPN dient nicht nur dazu da, um illegale Aktivitäten perfekt zu verschleiern, sondern dient in erster Linie dazu da um eine sichere und getunnelte Verbindung zu einem Server aufzubauen. Oft wird VPN im Zusammenhang mit Anonymität und Kriminalität erwähnt, da die Verbindung geographisch in verschiedenen Teilen der Welt kaskadiert werden kann um die Ursprungsanfrage, samt der IP-Adresse des Users zu anonymisieren. Es ist auch nicht zu leugnen, dass VPN auch für diese Zwecke genutzt werden kann, jedoch ist dies nicht der alleinige Grund für seine Popularität. So können mittels dieser Technik auf Werbung und Webseite, welche Schadsoftware verbreiten, blockiert werden. Es gibt somit viele gute Gründe warum einen VPN-Dienst in Anspruch genommen werden sollte, welche wir Ihnen in diesem Artikel näher erläutern. Wenn Sie Ihre Datenverbindung über ihr Mobiltelefon verbinden, dann müssen Sie darauf achten, dass Sie sich wirklich per W-LAN mit ihrem Netzwerk verbinden und nicht mittels Edge, 3g oder LTE, da diese nicht die Verbindung mit ihrem Router bzw. Modem aufbauen, sondern mit dem Funkmast. Hierbei werden andere Komponente von ihren Geräten angesprochen. Es ist im Prinzip daselbe, da Sie sich mit ihren Endgeräten mit einer Zwischenstelle verbinden und dann die Verbindung zum Internet hergestellt wird.

Sie müssen wissen, dass die Verbindung aller ihre Geräte mit ihrem Router, in einem eigenständigen Netzwerk sind. Ihre Geräte sind also in einem geschlossenen oder auch fachlich gesagt, in einem lokalen Netzwerk. Diese Geräte können untereinander kommunizieren. So ist es beispielsweise möglich, dass Sie mit ihrem Smartphone oder allen ihren Computern, welche im privaten Netzwerk sind, auch gemeinsam drucken oder scannen können. Sie müssen bewusst sein, dass sie untereinander nicht nur diese Dienste teilen können, sondern auch auf gemeinsam geteilte Ordner etc. Wenn Sie sich mit einem Endgerät z.B. mit ihrem Drucker Zuhause verbinden, dann stellt Ihr Computer erst eine Verbindung zum Router her und von dort aus wird dann mit dem Drucker direkt kommuniziert. Sie sprechen also nicht die Geräte über das Internet an, sondern innerhalb ihres lokalen Netzwerkes. Dieses Netzwerk mit ihrem Router fungiert als autonomes Netzwerk.

Es ist deshalb wichtig, dass Sie dieses Netzwerk auch nicht zugänglich für andere machen, indem Sie jedem ihr W-LAN Passwort geben. Durch die Weitergabe ihres W-LAN Passworts, können beispielsweise ihre komplette Kommunikation zwischen ihren Geräten und dem Router z.B. mit WireShark abgehört werden.

In ihrem privaten bzw. lokalen Netzwerk erhalten Sie von ihrem Router standardmäßig eine interne IP-Adresse. Diese IP-Adresse ist zu unterscheiden, mit dem, welches Sie von ihrem Internet-Anbieter erhalten. Die interne IP-Adresse ist nur gültig in ihrem eigenen lokalen Netzwerk und nicht sichtbar, wenn Sie im Internet sind. Sobald Sie zum Beispiel sich mit einer Webseite verbinden, dann wird ihre öffentliche IP-Adresse übermittelt, welche von ihrem Internet-Anbieter (Internet-Service-Provider) zugewiesen worden ist. Die unterscheidet sich aber komplett von ihrer IP-Adresse in ihrem privaten Netzwerk. Es sind also zwei paar Stiefel und darf nicht verwechselt werden, da es komplett zwei verschiedene Netze (privat und öffentlich) sind.

Diese öffentliche IP-Adresse ist meistens 24 Stunden gültig und Sie erhalten danach eine neue Adresse. So wird es auch für alle anderen im Internet schwierig, den eigentlichen Anschlussinhaber durch die IP-Adresse zu ermitteln, solange keine Straftat begangen - und diese Zeitnah gemeldet wurde. Die öffentliche IP-Adresse zum jeweiligen Anschlussinhaber wird nämlich nur für einen begrenzten Zeitraum gespeichert und protokolliert, sodass eine Strafanzeige rechtzeitig erfolgen muss.

Eine VPN-Verbindung ermöglicht Ihnen virtuell ein lokales bzw. privates Netzwerk zu erstellen. Damit genießen Sie die gleichen Vorteile eines privaten Netzwerks, ohne physisch wirklich anwesend zu sein. So lässt sich auch die Begrifflichkeit „virtual“ in dem Wort VPN erklären. Sie können also ein Büro jeweils am Standort Berlin und München haben. Mit VPN, können Sie dann diese zwei privaten Netzwerke mit VPN verkoppeln und sind dann im gleichen Netzwerk. Die Flexibilität dieser Technik, eröffnet Ihnen neue und mehrere Möglichkeiten, z.B. sich mit mehreren Standorten über die Ferne über das Internet, abgesichert zu verbinden, egal wo Sie sich im momentan auf der Welt befinden. Die Distanz ist hierbei komplett irrelevant und macht sich, wenn überhaupt an der Geschwindigkeit bemerkbar, wenn an dem Empfangsort (VPN-Server) die Upload-Bandbreite das Maximum erreicht hat und die physikalischen Gegebenheiten keine höhere Bandbreite zulässt. Sie können also eine permanente und stabile VPN-Verbindung zwischen den beiden Standorten konfigurieren. Die Verbindung kann so, von einem Ende der Welt zur anderen verlaufen, ohne das Sie Angst haben müssen gläsern zu sein.

Dann sind Sie mit uns als IT Service in München in besten Händen. Wir bieten Ihnen eine umfassende IT-Betreuung zum Thema VPN und Sicherheit im Netz an. Wir erledigen für Sie den kompletten Prozess von der Planung bis hin zur Einrichtungn ihres eigenen VPN-Netzwerks. Vielleicht aber möchten Sie auch nur Unterstützung zu diesem Thema haben, wie Sie sich via VPN in andere Unternehmensnetzwerke einloggen können, da Sie mit Unternehmen kooperieren. Egal ob Sie VPN für private Zwecke nutzen möchten oder für den Business-Bereich, mit uns sind Sie gut beraten. Rufen Sie uns einfach unter der Rufnummer 0176 / 75 19 18 18 an und vereinbaren Sie unverbindlich einen Termin!

VPN-Verbindungen sind keineswegs eine neue Erfindung, aber gerade jetzt beginnen sie in der breiten Öffentlichkeit mehr und mehr an Bedeutung zu gewinnen, obwohl die Technik in vielen Bereichen Anwendung findet. Häufig hat man Berührungspunkte mit diesem Thema im Geschäftsumfeld. Dabei steht VPN nicht nur für Sicherheit und für Verschlüsselung. Die Technik wird zwar häufig hierfür verwendet, aber in diesem Artikel erläutern wir Ihnen wie die Technik funktioniert und warum sie sich hervorragend zur Anonymisierung eignet. Durch die vielseitigen Anwendungsmöglichkeiten, sind auch die Einsatzmöglichkeiten hierfür auch ziemlich groß und bei vielen beliebt.

Beginnen wir mit den Grundlagen von VPN. Die Wortkombination bedeutet Virtual Private Network. Daraus kann abgeleitet werden, worum es ungefähr geht. Beim VPN handelt es sich ins Deutsche übersetzt, also um ein virtuelles und privates Netzwerk. Anhand der Abkürzung kann man eher darauf Rückschlüsse ziehen, wofür es genau steht und was damit gemacht werden kann, gegenüber Begriffen wie z.B. DNS oder HTTPS.

Wie aus dem Wort VPN entnehmen zu ist, handelt es sich in erster Linie, wie bereits geschildert, um ein privates Netzwerk. So ein Netzwerk haben Sie auch bei sich Zuhause oder in der Firma. Jedes Gerät, welches Sie Zuhause oder im Office besitzen und mit dem Internet verbunden sind, gehören zum selben Netzwerk. Sprich, sie haben ein kleines Netzwerk bei sich Zuhause, wo die Geräte untereinander kommunizieren können, auch ohne Internet. Das gleiche lässt sich auch bei Firmen anwenden. Alle Computer (Clients) sind untereinander verbunden und ergeben so ein privates Netzwerk.

So erhalten beispielsweise Ihr Mobiltelefon, Tablet, Laptop, Konsolen oder ihre Smarthome-Geräte (IoT) immer eine private IP-Adresse, beginnend mit 192.168.XXX.XXX. Die Geräte verbinden sich mit Ihrem Standardgateway, welches Ihr Router ist. Das ist das erste Gerät, welches bei Ihnen nach der TAE Dose angesteckt ist (Bild TAE Dose). Der gängigsten Router-Hersteller sind AVM (FritzBox), Netgear, D-Link, TP-Link oder Speedport (Telekom) und EasyBox (Vodafone). Heutzutage handelt es sich jedoch nicht nur um einen einzelnen Router, sondern diese haben in der Regel auch ein Modem und ein Switch eingebaut. Die Endgeräte, welche bei Ihnen in Anwendung kommen, verbinden sich entweder über ein LAN-Kabel oder mittels W-LAN mit ihrem Router. Der Router wiederum routet die Signale an den Modem. Ihr Modem stellt dann die Verbindung mit ihrem Internet-Provider her. Alle Geräte, welche Sie mit LAN an ihrem Router angesteckt haben, werden mit dem integrierten Switch verbunden. Ein einzelnes Modem hat beispielsweise auch nur ein LAN Ein- bzw. Ausgang, deshalb ist ein Switch notwendig um mehrere Geräte miteinander mit einem Kabel zu verbinden.

Damit haben wir Anhand der Begrifflichkeit hervorragend die Grundlagen ebnen können. So und was kann man mit VPN denn nun machen?

Teil drei unserer Artikelreihe zum Umstieg auf Apple-Produkte dreht sich ganz um die Firmenpolitik des US-Konzerns. Wir behandeln sowohl Sicherheit und Datenschutz als auch den technischen Support.

Natürlich spielt auch die Sicherheit eine enorme Rolle bei Apples Macs. Gemeinhin werden die Geräte von Apple als sehr sicher beziehungsweise weitaus sicherer als Windows-Geräte aufgefasst. Da der Marktanteil an Apple-Geräten weltweit zwischen 10 und 15 Prozent liegt, ist es nicht verwunderlich, dass für die weitaus weiter verbreiteten Windows-Rechner mehr Schadsoftware gibt als für Macs. Dies liegt schlicht daran, dass die Entwicklung von Viren und Trojanern lukrativer ist, da man mehr System angreifen kann.

Das besagt grundsätzlich allerdings noch nichts darüber aus, ob Macs sicherer sind. Es gibt zwar weniger Viren, Sicherheitslücken gibt es allerdings auch bei MacOS. Und zwar teils gravierende, die immer wieder publik werden – und sicherlich auch von Hackern ausgenutzt werden.

Grundsätzlich gelten für den Mac natürlich genau die gleichen Prinzipien wie für Windows-Rechner, wenn es um die Sicherheit geht: Die besten Sicherheitseinstellungen helfen nichts, wenn der Nutzer sorglos jede Software installiert oder jeden Link anklickt, der ihm per Mail zugeschickt wird. Meist ist eben der Nutzer die Schwachstelle eines Systems. Es hilft also auch hier, sich der Gefahren des Internets bewusst zu sein und sich dementsprechend verantwortungsvoll zu verhalten.

Eine andere Frage hingegen stellt der Datenschutz dar. Apple ist ein amerikanisches Unternehmen und damit dem amerikanischen Recht untergeordnet. Nehmen wir als Beispiel die iCloud. Auch wenn die Server vielleicht in Europa stehen mögen, gilt der Patriot Act auch für die Daten, die auf diesen Servern gespeichert sind, da Apple diesem Gesetz Folge leisten muss. Wie bereits näher im Artikel über Cloud-Lösungen erläutert, gelten also für alle Daten, die in die iCloud hochgeladen werden, nicht die deutschen Datenschutzgesetze oder die DSGVO der Europäischen Union.

Dies ist natürlich nicht das alleinige Problem von Apple-Produkten. Das Gleiche gilt auch für Microsoft und Google. Das ändert jedoch nichts daran, dass das Nutzen der gesamten „Apple-Lösung“ immer damit verbunden ist, dass deutsches Recht und vor allem Ihre Privatsphäre ignoriert werden.

Sollten Sie mit Desktop-PCs Erfahrung haben, werden Sie vielleicht wissen, wie einfach es sein kann, einen defekten Arbeitsspeicher auszutauschen oder eine neue Festplatte in Ihren Rechner einzubauen. Bei Laptops sieht es hingegen etwas komplizierter aus, da aufgrund der kompakten mobilen Bauweise manche Komponenten nur schwierig zu erreichen sind.

Und wie sieht es da bei Apple-Produkten aus? Da sagt Apple ganz klar: Finger weg! Aufschrauben und reparieren darf nur, wer offiziell für die US-Amerikaner arbeitet oder der eine Genehmigung von ihnen hat. Bastelt man trotzdem an dem Gerät herum, erlischt die Garantie.

Im ersten Moment ist es ja nachvollziebar, dass möglichst nur Profis an das Gerät sollten, doch wenn man jedes Mal, wenn irgendetwas mit der Hardware nicht in Ordnung ist, zum nächsten Apple-Shop rennen und sein Gerät abgeben muss, kann das sehr nervig sein. Vor allem, wenn offensichtlich systematisch Fehler auftreten. Beispielsweise mit den Tastaturen der letzten MacBook Pro Generationen, die regelmäßig defekt waren – und die Apple trotzdem weiterhin in die jeweils neue Generation Geräte eingebaut hat.

Während es schon eine Frechheit ist, defekte Bauteile einzubauen, obwohl die Probleme damit bereits seit Langem bekannt sind, grenzt es schon an eine Unverschämtheit, dafür auch noch eine Menge Geld zu verlangen. Denn Apple sah es lange Zeit überhaupt nicht ein, für die selbst gemachten Fehler geradezustehen.

Mittlerweile (nach mehreren Jahren wohlgemerkt) scheinen die Fehler weitestgehend behoben zu sein und die älteren Geräte wurden in ein Programm aufgenommen, die einen kostenlosen Support garantieren. Dass dies aber so lange dauern musste, spricht nicht wirklich für die Kundenfreundlichkeit der US-Amerikaner.

Wenn das Geld allerdings keine allzu große Rolle spielt (beispielsweise, wenn die Firma die Kosten von Reparaturen übernimmt), bekommt man auch hochqualitativen und meist recht schnellen Support geboten. Das scheint allerdings ein generelles Selbstverständnis von Apple zu sein: für Geld bekommt man alles.

Neben all den Unterschieden ähneln sich MacOS und Windows letztlich in vielen Belangen sehr. Wie bereits erwähnt sind es Detailfragen, die sich unterscheiden. Viele Elemente des einen Systems finden sich in anderer Form genauso auf dem anderen, beispielsweise ein Sprachassistent oder der Appstore. Microsoft entwickelt sein Betriebssystem zunehmend in eine ähnliche Richtung wie Apple, wenn auch letztere noch sehr viel stärker auf Stil und All-in-one-Lösungen setzen.

Wenn alles rund läuft mit den Apple-Produkten (was normalerweise auch der Fall ist), sind diese Geräte hervorragende Computer. Das Problem ist eher, wenn mal etwas nicht rund läuft oder defekt ist. Da ist der Aufwand im Allgemeinen größer als bei Windows-Rechnern.

Letzten Endes ist es auch eine Geschmacksache, welchem Betriebssystem beziehungsweise welcher Hardware man den Vorzug gibt. Beide Systeme haben ihre Daseinsberechtigung und ihre ganz eigenen Vor- und Nachteile.

Im ersten Teil dieses Erfahrungsberichts ging es um die grundlegenden Eigenheiten von Apples Betriebssystem MacOS. Heute geht es in erster Linie darum, wie es sich mit einem neuen MacBook Pro aus diesem Jahr arbeitet.

Und da liegt auch der Grundgedanke von Apple: Die US-Amerikaner wollen, dass der Nutzer möglichst nicht nachdenkt beziehungsweise nachdenken muss. Einerseits ist das löblich, dass alles wie von selbst ablaufen soll und sich der User auf das wirklich Wichtige konzentrieren kann.

Mir ist allerdings immer wieder aufgefallen, dass es einige Stellen gibt, an denen diese perfekte Apple-Oberfläche Kratzer bekommt. Ein Beispiel hierfür ist der systemeigene, Finder genannte, Explorer, den Mac verwendet. Vielleicht bin ich einfach zu sehr von Windows beeinflusst, aber die Tatsache, dass der Finder häufig nicht aktualisiert, wenn gerade eine Datei im geöffneten Ordner gespeichert wurde oder dass das Ausschneiden und Verschieben nur mit der Maus, aber nicht immer mit Shortcuts funktioniert, kann einfach keine gute Designentscheidung sein.

Es stört den Arbeitsablauf nämlich gehörig, wenn der Finder schlichtweg nicht seine Aufgabe erfüllt, für die er vorgesehen ist. Das sind Kleinigkeiten, die mich zeitweise aber gehörig fluchen haben lassen. Ähnlich wie bei Pages heißt es dann für mich: Eine Alternative muss her. Und die gibt es tatsächlich. Unterschiedliche Entwickler bieten für den Mac Dateiverwaltungssoftware an – allerdings oft nicht kostenlos. Bei einem so hohen Preis, den Apple für seine Geräte verlangt, sollte man eigentlich erwarten können, dass die Software dann auch funktioniert und man nicht noch mehr Geld ausgeben muss, damit das grundlegende System reibungsfrei läuft.

Apple ist dafür bekannt, immer mal wieder einen eigenen Standard einzuführen und sich gezielt von der Konkurrenz abheben zu wollen - auch, wenn das in manchen Fällen mehr aus Prinzip oder aus wirtschaftlichen Interessen geschieht als aus anderen nachvollziehbaren Gründen.

Während sich das beim USB-C Anschluss mit dem Namen Thunderbolt durchaus rentiert hat (immerhin wird der kommende USB 4 Standard offiziell auf Thunderbolt-Technologie aufbauen), ist es bei den hauseigenen Tastaturen nicht vollständig nachvollziehbar.Letztlich bietet die Apple-Tastatur nicht unbedingt mehr Funktionen als andere hochwertige Tastaturen - die Funktionstasten werden nur anders bezeichnet.

Zugutehalten muss man Apple diesbezüglich, dass die Peripherie standardmäßig tief in das Betriebssystem integriert ist und beispielsweise die Tastenkombinationen in den Menüpunkten immer mit angezeigt werden, was durchaus einen höheren Komfort bietet als bei Windows oder Linux, wo man die Tastaturkürzel meist auswendig wissen muss, um sie zu verwenden.

Gerade für den Umstieg auf einen Mac ist dies sehr von Vorteil, da man sich lästiges Nachschlagen im Handbuch oder Suchen im Internet sparen kann. Sobald man sich einmal in ein Windows- oder Linux-System eingearbeitet hat und die Befehle und Shortcurts kennt, ist dieser Vorteil des Macs natürlich wieder dahin, allerdings gestaltet sich damit der Um- beziehungsweise Einstieg in iOS wesentlich angenehmer.

Dennoch wäre es wünschenswert, dass Apple standardmäßig eine vollständige Unterstützung von Tastaturen anbieten würde, die nicht von Apple selbst stammen. Dass die Kalifornier hiermit natürlich die Kunden an sich binden möchte ist verständlich - aber wer sich schon einen vergleichsweise teueren Mac kauft, sollte nicht auch noch mit einer Tastatur für 150 Euro behelligt werden.

Wenn wir schon beim Thema Tastatur sind: Als ich den oben stehenden Abschnitt über die Peripherie geschrieben habe, hat mein neues MacBook Pro meine USB-Tastatur noch halbwegs vernünftig akzeptiert. Mittlerweile kommt es aber zu häufigen Aussetzern, Verzögerungen und ähnlichen stark störenden Problemen. An der Tastatur selbst liegt es nicht, an anderen Geräten funktioniert sie nach wie vor einwandfrei. Warum die Kombination dieser Tastatur mit dem Mac solche Probleme macht, bleibt ein Rätsel. Allerdings waren die Probleme so schwerwiegend, dass eine neue Tastatur her musste – wieder 150 Euro auf das Konto von Apple.

Was bei MacOS allerdings richtig gut gelungen ist, sind die digitalen Bildschirme. Mit einem einfachen Wischen mit drei Fingern über das Touchpad wechselt man zum nächsten virtuellen „Schreibtisch“ genannten Desktop. Dadurch erübrigt sich in den meisten Fällen der Bedarf mehrerer Bildschirme. Das Gewische mag manche vielleicht stören, es spart aber enorm viel Platz auf dem Schreibtisch und und geht schneller und intuitiver von der Hand, als man sich das anfangs vorstellt. Apple hat einfach ein Händchen für derlei Funktionen.

Für manche Anwendungen oder Situationen mag ein zweiter Monitor allerdings immer noch praktikabler sein, das hängt natürlich vom Anwender und dem Anwendungsgebiet ab. Der Clou bei der Sache ist jedoch, dass dies alles auch mit mehreren angeschlossenen Bildschirmen funktioniert – und das auch für jeden separaten „echten“ Bildschirm! Soll bedeuten, dass ich auf mehreren angeschlossenen Bildschirm jeweils beliebig viele virtuelle Schreibtische habe, zwischen denen ich hin und her wischen kann. Damit geht selbst bei aufwendigeren Recherchetätigkeiten die Arbeit leicht und intuitiv von der Hand. Und das sagt jemand, der seit jeher mit Windows gearbeitet hat und lange Zeit die Apple-Produkte als teures Spielzeug abgetan hat.

Im dritten und letzten Teil dieser Artikelreihe wird es um Themen wie Datenschutz und um den technischen Support durch Apple gehen.

Sollten Sie Hilft beim Umstieg auf Apple-Geräte benötigen, wenden Sie sich gerne vertrauensvoll an uns! Unsere qualifizierten IT-Spezialisten lösen jedes Ihrer Computer-Probleme! Kontaktieren Sie uns jederzeit: